BEVFormer 논문 번역

tesla 에서 발표한 occupancy network을 공부하던중

BEVFormer: Learning Bird’s-Eye-View Representation from Multi-Camera Images via Spatiotemporal Transformers 해당 논문이 근간이 되는 논문인것 같아서 chat gpt 의 도움을 받아 번역해봄.

Tesla AI day 나온 BEV transform은 다른 방식 일 수 있지만 해당 논문이 가장 근접한 것 같음.

원문을 읽고 공부해야하지만 번역본을 읽어 보고 감을 잡고 하면 좋을것 같아서 번역해봄.

요약

자율 주행 시스템에서 3D 탐지 및 지도 분할과 같은 3D 시각 인식 작업은 필수적입니다. 이 연구에서는 다중 카메라 이미지를 기반으로 한 통합 BEV 표현을 지원하기 위해 공간-시간 변환기를 활용하는 BEVFormer라는 새로운 프레임워크를 제안합니다. BEVFormer는 사전 정의된 그리드 형태의 BEV 쿼리를 통해 공간 및 시간 정보를 상호 작용시켜 공간 및 시간 공간과 상호 작용합니다. 공간 정보를 집계하기 위해, 우리는 각 BEV 쿼리가 카메라 뷰를 통해 관심 영역에서 공간적인 특징을 추출하는 공간 교차 어텐션을 설계했습니다. 시간 정보에 대해서는, 우리는 역사적인 BEV 정보를 반복적으로 융합시키는 시간적인 자기 어텐션을 제안합니다. 우리의 접근 방식은 nuScenes 테스트 세트에서 NDS 지표를 기준으로 새로운 최고 성능 56.9%를 달성하였으며, 이는 이전 최고 기법보다 9.0 점 높으며 LiDAR 기반 기준과 유사한 성능을 보입니다. 또한, BEVFormer가 낮은 가시성 조건에서의 속도 추정 및 물체 회수 정확도를 현격히 개선하는 것을 보여줍니다. 코드는 https://github.com/zhiqi-li/BEVFormer 에서 확인할 수 있습니다.

1 Introduction

자율 주행, 로봇 등 다양한 응용 분야에서 3D 공간에서의 인식은 중요합니다. LiDAR 기반 방법들의 현저한 발전에도 불구하고, 최근에는 카메라 기반 접근법들이 큰 관심을 받고 있습니다. 배치 비용이 낮고, 카메라는 LiDAR 기반 대안에 비해 장거리 거리 객체를 감지하고 시각 기반 도로 요소 (예: 신호등, 정지선)를 식별하는 데 이점을 가지고 있기 때문입니다.

자율 주행에서 주변 장면의 시각적 인식은 여러 카메라에서 제공되는 2D 힌트를 기반으로 3D 경계 상자나 시맨틱 맵을 예측하는 것을 목표로 합니다. 가장 직관적인 솔루션은 단안 프레임워크와 카메라 간 후처리입니다. 이 프레임워크의 단점은 서로 다른 뷰를 개별적으로 처리하며 카메라 간 정보를 포착하지 못하므로 성능과 효율성이 낮다는 것입니다.

단안 프레임워크의 대안으로, 다중 카메라 이미지에서 전체적인 표현을 추출하는 통합된 프레임워크가 있습니다. Bird's-eye-view (BEV)는 주변 장면의 일반적으로 사용되는 표현으로, 객체의 위치와 크기를 명확히 보여주며 자율 주행과 같은 다양한 작업에 적합합니다. 이전의 맵 분할 방법들은 BEV의 효과를 보여줬지만 [32, 18, 29], 3D 객체 탐지에서 BEV 기반 접근법은 다른 패러다임과 비교해 큰 장점을 보여주지 못했습니다 [47, 31, 34]. 그 이유는 3D 객체 탐지 작업은 정확한 3D 경계 상자 예측을 지원하기 위해 강력한 BEV 특징이 필요하지만, 2D 평면에서 BEV를 생성하는 것은 잘 정의된 문제가 아닙니다. BEV 특징을 생성하는 인기있는 BEV 프레임워크는 깊이 정보를 기반으로 합니다 [46, 32, 34], 하지만 이 패러다임은 깊이 값이나 깊이 분포의 정확성에 민감합니다. 따라서 BEV 기반 방법의 탐지 성능은 복합 오차에 영향을 받고, 부정확한 BEV 특징은 최종 성능을 심각하게 저해할 수 있습니다. 그래서 우리는 깊이 정보에 의존하지 않고 BEV 특징을 적응적으로 학습할 수 있는 BEV 생성 방법을 설계하고자 하는 동기를 갖게 되었습니다. 가치 있는 특징을 동적으로 집계하기 위해 어텐션 메커니즘을 사용하는 Transformer는 개념적으로 우리의 요구 사항을 충족시킵니다.

인식 작업을 수행하기 위해 BEV 특징을 사용하는 또 다른 동기는 BEV가 시간적 및 공간적 공간을 연결하는 좋은 다리 역할을 한다는 것입니다. 인간의 시각 인지 시스템에서 시간 정보는 객체의 움직임 상태를 추론하고 가려진 객체를 식별하는 데 중요한 역할을 합니다. 비전 분야의 많은 연구들이 비디오 데이터를 사용하는 효과를 입증하였습니다. 그러나 기존의 최첨단 다중 카메라 3D 탐지 방법들은 시간 정보를 거의 활용하지 않습니다. 자율 주행은 시간적으로 중요하며 장면 내 객체는 빠르게 변화하기 때문에, 단순히 교차 타임스탬프의 BEV 특징을 쌓는 것은 추가 계산 비용과 간섭 정보를 가져올 수 있으며 이는 이상적이지 않을 수 있습니다. 우리는 순환 신경망 (RNN) [17, 10]의 영감을 받아 BEV 특징을 이용하여 과거에서 현재까지 시간적 정보를 반복적으로 전달하는 BEVFormer를 사용합니다. 이는 RNN 모델의 은닉 상태와 동일한 원리를 가지고 있습니다.

이를 위해, 우리는 다중 뷰 카메라와 과거 BEV 특징에서 공간적 및 시간적 특징을 효과적으로 집계할 수 있는 Transformer 기반의 Bird's-eye-view (BEV) 인코더인 BEVFormer를 제안합니다. BEVFormer에서 생성된 BEV 특징은 3D 객체 탐지와 맵 분할과 같은 다중 3D 인식 작업을 동시에 지원할 수 있으며, 이는 자율 주행 시스템에 가치가 있습니다. Fig. 1에서 보여지듯이, BEVFormer는 다음과 같은 세 가지 주요 설계 요소를 포함합니다: (1) 격자 모양의 BEV 쿼리를 통해 어텐션 메커니즘을 통해 공간적 및 시간적 특징을 유연하게 통합, (2) 다중 카메라 이미지에서 공간적 특징을 집계하기 위한 공간적 교차 어텐션 모듈, 그리고 (3) 과거 BEV 특징에서 시간적 정보를 추출하기 위한 시간적 자기 어텐션 모듈. 이러한 설계는 이동 객체의 속도 추정과 가려진 객체의 탐지에 유리하며, 추가 계산 비용은 거의 없습니다. BEVFormer에서 생성된 통합 특징을 사용하여, Deformable DETR [56] 및 마스크 디코더 [22]와 같은 작업별 헤드와 협업하여 엔드 투 엔드 3D 객체 탐지 및 맵 분할을 수행할 수 있습니다.

우리의 주요 기여는 다음과 같습니다:

• 우리는 BEVFormer를 제안합니다.

이는 다중 카메라 및/또는 타임스탬프 입력을 BEV 표현으로 투영하는 시공간 변형기 인코더입니다. 통합된 BEV 특징을 사용하여 우리의 모델은 3D 탐지 및 맵 분할을 포함한 다중 자율 주행 인지 작업을 동시에 지원할 수 있습니다.

• 우리는 학습 가능한 BEV 쿼리를 설계하였으며, 이는 공간 교차 어텐션 레이어와 시간적 자기 어텐션 레이어와 함께 사용됩니다. 이를 통해 교차 카메라에서 공간적인 특징을 조회하고, 과거 BEV에서 시간적인 특징을 조회한 후, 이를 통합된 BEV 특징으로 집계합니다.

• 우리는 nuScenes [4]와 Waymo [40]를 포함한 여러 어려운 벤치마크에서 제안한 BEVFormer를 평가하였습니다.

BEVFormer는 이전 연구들과 비교하여 일관적으로 개선된 성능을 달성합니다. 예를 들어, 비교 가능한 매개 변수와 계산 비용 하에서, BEVFormer는 nuScenes 테스트 세트에서 56.9%의 NDS를 달성하며, 이는 이전 최고 탐지 방법 DETR3D [47]보다 9.0 포인트 높은 성능입니다 (56.9% 대 47.9%). 맵 분할 작업에서도, 가장 어려운 차선 분할에서 Lift-Splat [32]보다 5.0 포인트 이상 높은 최첨단 성능을 달성하였습니다. 우리는 이 간단하고 강력한 프레임워크가 후속 3D 인지 작업에 대한 새로운 기준선으로 사용될 수 있기를 희망합니다.

2 Related Work

2.1 Transformer-based 2D perception

최근에는 transformer를 사용하여 탐지 및 분할 작업을 재정립하는 새로운 동향이 있습니다 [7, 56, 22]. DETR [7]은 객체 쿼리 집합을 사용하여 교차 어텐션 디코더를 통해 탐지 결과를 생성합니다. 그러나 DETR의 주요 단점은 교육 시간이 오래 걸린다는 것입니다. Deformable DETR [56]은 변형 가능한 어텐션을 제안함으로써 이 문제를 해결합니다. DETR의 일반적인 전역 어텐션과는 달리, 변형 가능한 어텐션은 주변 관심 영역과 상호 작용하여 각 참조점 주변의 K개의 점을 샘플링하고 어텐션 결과를 계산하여 효율성을 높이고 교육 시간을 크게 단축합니다. 변형 가능한 어텐션 메커니즘은 다음과 같이 계산됩니다:

DeformAttn(q, p, x) = Nhead∑ i=1 Wi Nkey ∑ j=1 Aij · W′ i x(p + ∆pij ),

(1) 여기서 q, p, x는 각각 쿼리, 참조점 및 입력 특징을 나타냅니다.

i는 어텐션 헤드를 인덱싱하며,

Nhead는 총 어텐션 헤드 수를 나타냅니다.

j는 샘플링된 키를 인덱싱하며,

Nkey는 각 헤드에 대해 샘플링된 키의 총 수입니다.

Wi ∈ RC×(C/Hhead) 및 W ′ i ∈ R(C/Hhead)×C는 학습 가능한 가중치입니다.

여기서 C는 특징 차원을 나타냅니다.

Aij ∈ [0, 1]은 예측된 어텐션 가중치로, ∑Nkey j=1 Aij = 1로 정규화됩니다.

∆pij ∈ R2는 참조점 p에 대한 예측된 오프셋입니다.

x(p + ∆pij)는 Dai et al. [12]에서와 같이 이중 선형 보간법을 사용하여 위치 p + ∆pij에서 추출된 특징을 나타냅니다.

이 작업에서는 변형 가능한 어텐션을 3D 인지 작업에 확장하여 공간 및 시간 정보를 효율적으로 집계합니다.

2.2 Camera-based 3D Perception

이전의 3D 인지 방법은 일반적으로 3D 객체 탐지 또는 맵 세분화 작업을 독립적으로 수행합니다. 3D 객체 탐지 작업의 경우, 초기 방법은 2D 탐지 방법과 유사합니다 [1, 28, 49, 39, 53], 일반적으로 2D 바운딩 박스를 기반으로 3D 바운딩 박스를 예측합니다. Wang et al. [45]는 고급 2D 탐지기인 FCOS [41]를 따르며 각 객체에 대해 직접적으로 3D 바운딩 박스를 예측합니다. DETR3D [47]는 2D 이미지에서 학습 가능한 3D 쿼리를 투영하고, NMS 후 처리 없이 엔드 투 엔드 3D 바운딩 박스 예측을 위해 해당 기능을 샘플링합니다. 다른 솔루션은 이미지 특징을 BEV 특징으로 변환하고 위에서 아래로 3D 바운딩 박스를 예측하는 것입니다. 방법은 깊이 추정을 통해 이미지 특징을 BEV 특징으로 변환하거나 범주형 깊이 분포 [34]와 함께 사용합니다. OFT [36] 및 ImVoxelNet [37]은 미리 정의된 복셀을 이미지 특징에 투영하여 장면의 복셀 표현을 생성합니다. 최근에는 M2BEV [48]가 BEV 특징을 기반으로 여러 인지 작업을 동시에 수행하는 가능성을 더 탐구했습니다.

실제로, 여러 카메라 특징에서 BEV 특징을 생성하는 방법은 맵 세분화 작업에서 더 광범위하게 연구되었습니다 [32, 30]. 직관적인 방법은 역 투영 매핑 (Inverse Perspective Mapping, IPM) [35, 5]을 통해 원근 투시를 BEV로 변환하는 것입니다. 또한 Lift-Splat [32]은 깊이 분포를 기반으로 BEV 특징을 생성합니다. 방법 [30, 16, 9]은 다중 레이어 퍼셉트론을 활용하여 원근 투시를 BEV로 변환하는 것을 학습합니다. PYVA [51]는 전면 시점 단안 이미지를 BEV로 변환하는 교차 보기 transformer를 제안하지만, 이 패러다임은 전역 어텐션 메커니즘 [42]의 계산 비용 때문에 다중 카메라 특징을 융합하는 데 적합하지 않습니다. 공간 정보 외에도 이전 연구 [18, 38, 6]는 이전 타임스탬프에서 BEV 특징을 쌓음으로써 시간 정보를 고려합니다. BEV 특징을 쌓으면 고정된 시간 범위 내에서 사용 가능한 시간 정보를 제한하고 추가적인 계산 비용을 초래합니다. 이 작업에서는 제안된 공간 및 시간 transformer가 공간 및 시간 정보를 모두 고려하여 현재 시간의 BEV 특징을 생성하며, 시간 정보는 이전 BEV 특징에서 RNN 방식으로 얻어지며 거의 계산 비용이 없습니다.

3 BEVFormer

다중 카메라 이미지 특징을 Bird's-eye-view (BEV) 특징으로 변환하면 다양한 자율주행 인지 작업을 위한 통합된 주변 환경 표현을 제공할 수 있습니다. 이 작업에서는 다중 뷰 카메라 및 이전 BEV 특징에서 공간-시간 특징을 효과적으로 집계하기 위한 transformer 기반의 새로운 프레임워크인 BEVFormer를 제안합니다.

3.1 전체 아키텍처

Fig. 2에 설명된 것처럼, BEVFormer는 6개의 인코더 레이어로 구성되어 있습니다. 각 레이어는 transformer [42]의 전통적인 구조를 따르지만, BEV queries, spatial cross-attention, temporal self-attention이라는 세 가지 맞춤형 디자인이 추가되었습니다. 특히, BEV queries는 그리드 모양의 학습 가능한 매개 변수로, attention 메커니즘을 통해 다중 카메라 뷰에서 BEV 공간의 특징을 조회하기 위해 설계되었습니다. 공간 교차 어텐션과 시간 자기 어텐션은 BEV queries와 함께 작동하는 어텐션 레이어로, BEV 쿼리에 따라 다중 카메라 이미지에서 공간적인 특징 및 이전 BEV에서 시간적인 특징을 조회하고 집계합니다.

추론 중에는 타임스탬프 t에서 다중 카메라 이미지를 백본 네트워크 (예: ResNet-101 [15])에 입력하고 다른 카메라 뷰의 특징 Ft = {F i t }Nview i=1을 얻습니다. 여기서 F i t는 i번째 뷰의 특징이고, Nview는 카메라 뷰의 총 개수입니다. 동시에 이전 타임스탬프 t-1에서 BEV 특징 Bt−1을 보존합니다. 각 인코더 레이어에서는 먼저 BEV queries Q를 사용하여 이전 BEV 특징 Bt−1에서 시간적인 정보를 질의합니다. 그런 다음 BEV queries Q를 사용하여 다중 카메라 특징 Ft에서 공간적인 정보를 조회하기 위해 공간 교차 어텐션을 사용합니다. feed-forward 네트워크 [42] 후에 인코더 레이어는 다듬어진 BEV 특징을 출력하며, 이는 다음 인코더 레이어의 입력이 됩니다. 6개의 스택된 인코더 레이어 후에 현재 타임스탬프 t에서 통합된 BEV 특징 Bt가 생성됩니다. BEV 특징 Bt를 입력으로 사용하여 3D 검출 헤드 및 맵 세그멘테이션 헤드는 3D 바운딩 박스 및 시맨틱 맵과 같은 인지 결과를 예측합니다.

3.2 BEV Queries

BEVFormer에서 BEVFormer의 쿼리로 미리 정의된 그리드 형태의 학습 가능한 매개 변수 Q ∈ RH×W×C를 사용합니다. 여기서 H와 W는 BEV 평면의 공간적인 형태입니다. 구체적으로, Q의 위치 p = (x, y)에 있는 Qp ∈ R1×C 쿼리는 BEV 평면의 해당 그리드 셀 영역에 대한 역할을 수행합니다. BEV 평면의 각 그리드 셀은 실제 세계의 크기인 s 미터에 해당합니다. BEV 특징의 중심은 기본적으로 자동차의 위치에 해당합니다. 일반적인 관행을 따라 BEV 쿼리 Q에 학습 가능한 위치 임베딩을 추가하고 BEVFormer에 입력하기 전에 처리합니다.

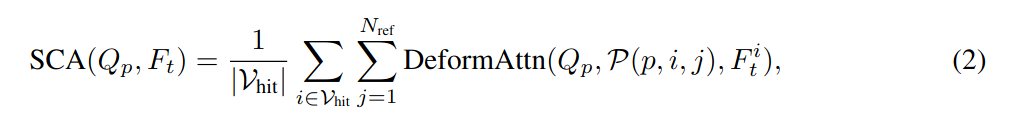

3.3 공간 교차

어텐션 다중 카메라 3D 인지 (Nview 카메라 뷰를 포함)의 큰 입력 규모로 인해 vanilla multi-head attention [42]의 계산 비용이 매우 높습니다. 따라서 각 BEV 쿼리 Qp가 카메라 뷰 간의 관심 영역과 상호 작용하는 리소스 효율적인 어텐션 레이어인 변형 어텐션 [56]을 기반으로 한 공간 교차 어텐션을 개발합니다. 그러나 변형 어텐션은 원래 2D 인지를 위해 설계되었으므로 3D 장면에 대한 일부 조정이 필요합니다.

Fig. 2 (b)에 나와 있는 것처럼, 우리는 먼저 BEV 평면의 각 쿼리를 pillar 형태의 쿼리로 변환하고, 해당 pillar에서 Nref 개의 3D 참조 포인트를 샘플링한 다음 이러한 포인트를 2D 뷰로 투영합니다. 하나의 BEV 쿼리에 대해 투영된 2D 포인트는 일부 뷰에만 위치할 수 있고, 다른 뷰는 투사되지 않습니다. 여기서 히트된 뷰를 Vhit로 지칭합니다. 그 후, 이러한 투영된 2D 포인트를 쿼리 Qp의 참조 포인트로 간주하고 Vhit 주변에서 특징을 샘플링합니다. 최종적으로 샘플링된 특징의 가중합을 공간 교차 어텐션의 출력으로 사용합니다. 공간 교차 어텐션(Spatial Cross-Attention)의 과정은 다음과 같이 정의할 수 있습니다:

SCA(Qp, Ft) = 1 |Vhit| ∑ i∈Vhit Nref∑ j=1 DeformAttn(Qp, P(p, i, j), F i t ), (2)

여기서 i는 카메라 뷰를 인덱싱하고, j는 참조 포인트를 인덱싱하며, Nref는 각 BEV 쿼리에 대한 총 참조 포인트입니다. F i t는 i번째 카메라 뷰의 특징입니다. 각 BEV 쿼리 Qp에 대해 투영 함수 P(p, i, j)를 사용하여 i번째 뷰 이미지의 j번째 참조 포인트에서 2D 포인트를 얻습니다.

다음으로, 투영 함수 P를 사용하여 뷰 이미지에서 참조 포인트를 어떻게 얻는지 알아봅시다. 우리는 먼저 BEV 쿼리 Qp의 p = (x, y)에 위치한 Qp에 해당하는 실제 위치 (x', y')를 Eqn. 3과 같이 계산합니다.

x' = (x− W 2 )×s; y' = (y− H 2 )×s, (3)

여기서 H와 W는 BEV 쿼리의 공간적 형태이고, s는 BEV의 그리드 해상도 크기이며, (x', y')는 자동차의 위치가 원점인 좌표입니다. 3D 공간에서 (x', y')에 위치한 객체는 z축 상의 높이 z'에서 나타납니다. 따라서 다른 높이에서 나타난 단서를 포착할 수 있도록 사전에 일련의 앵커 높이 {z'j}Nref j=1을 정의합니다. 이렇게 하면 각 쿼리 Qp에 대해 3D 참조 포인트 (x', y', z'j)Nref j=1의 pillar를 얻을 수 있습니다. 마지막으로, 카메라의 투영 행렬로 3D 참조 포인트를 다른 이미지 뷰로 투영합니다. 이는 다음과 같이 작성할 수 있습니다:

P(p, i, j) = (xij , yij )

여기서 P(p, i, j)는 j번째 3D 포인트 (x', y', z'j)에서 i번째 뷰에서 투사된 2D 포인트이며, Ti ∈ R3×4는 i번째 카메라의 알려진 투영 행렬입니다.

3.4 Temporal Self-Attention

공간 정보 외에도 주변 환경을 이해하는 데에는 시간 정보도 중요합니다 [27]. 예를 들어, 시간적인 단서 없이 정지 이미지에서 이동 객체의 속도를 추론하거나 매우 가려진 객체를 감지하는 것은 어렵습니다. 이러한 문제를 해결하기 위해 우리는 현재 환경을 표현하기 위해 이전 BEV 특징을 포함하는 시간적인 자기 어텐션(Temporal Self-Attention)을 설계합니다.

현재 타임스탬프 t에서의 BEV 쿼리 Q와 타임스탬프 t-1에서 보존된 이전 BEV 특징 Bt−1이 주어졌을 때, 우리는 운동 정보에 따라 Bt−1을 Q에 맞추어 같은 그리드의 특징이 같은 실제 위치에 해당하도록 정렬합니다. 여기서 우리는 정렬된 이전 BEV 특징 Bt−1을 B′t−1로 표시합니다. 그러나 t-1에서 t로 이동 가능한 객체는 다양한 오프셋으로 실제 세계에서 이동합니다. 따라서 다른 시간의 BEV 특징 사이에서 동일한 객체의 정확한 연관성을 구성하는 것은 어렵습니다. 이를 위해 우리는 시간적인 연결을 표현하기 위해 시간적 자기 어텐션(TSA) 레이어를 모델링합니다. 이는 다음과 같이 작성할 수 있습니다:

TSA(Qp, {Q, B′t−1}) = ∑ V ∈{Q,B′t−1} DeformAttn(Qp, p, V ), (5)

여기서 Qp는 p = (x, y)에 위치한 BEV 쿼리를 나타냅니다. 또한, vanilla deformable attention과는 달리 시간적 자기 어텐션에서의 오프셋 ∆p는 Q와 B′t−1의 연결로 예측됩니다. 특히, 각 시퀀스의 첫 번째 샘플의 경우, 시간적 자기 어텐션은 시간 정보가 없는 자기 어텐션으로 간주됩니다. 이 경우 BEV 특징 {Q, B′t−1}을 중복된 BEV 쿼리 {Q, Q}로 대체합니다.

[18, 38, 6]에서 단순히 BEV를 쌓는 것과 비교하여, 우리의 시간적 자기 어텐션은 더 효과적으로 장기적인 시간적 종속성을 모델링할 수 있습니다. BEVFormer는 여러 개의 BEV 특징을 쌓는 대신 이전 BEV 특징으로부터 시간 정보를 추출하므로, 계산 비용이 적고 방해되는 정보가 적습니다.

3.5 BEV 특징의 응용

BEV 특징 Bt ∈ RH×W ×C은 다양한 자율 주행 인식 작업에 사용할 수 있는 다용도의 2D 특징 맵입니다. 3D 객체 검출 및 맵 분할 작업 헤드는 2D 인식 방법 [56, 22]을 기반으로 작성될 수 있으며, 작은 수정이 필요합니다.

3D 객체 검출을 위해 2D 검출기인 Deformable DETR [56]을 기반으로 한 end-to-end 3D 검출 헤드를 설계합니다. 수정사항으로는 단일 스케일 BEV 특징 Bt를 디코더의 입력으로 사용하고, 2D 바운딩 박스 대신 3D 바운딩 박스와 속도를 예측하며, 3D 바운딩 박스 회귀를 지도하기 위해 L1 손실만 사용합니다. 검출 헤드를 사용하여 NMS 후 처리 없이도 3D 바운딩 박스와 속도를 end-to-end로 예측할 수 있습니다.

맵 분할을 위해 2D 분할 방법인 Panoptic SegFormer [22]를 기반으로 한 맵 분할 헤드를 설계합니다. BEV 기반의 맵 분할은 일반적인 의미적 분할과 기본적으로 동일하므로 [22]의 마스크 디코더와 클래스 고정 쿼리를 사용하여 자동차, 차량, 도로(주행 영역) 및 차선과 같은 각 의미적 카테고리를 대상으로 합니다.

3.6 Implementation Details

정보 학습 단계에서는 t 타임스탬프의 각 샘플에 대해 과거 2초의 연속 시퀀스에서 다른 3개의 샘플을 무작위로 추출합니다. 이 무작위 샘플링 전략은 자동차 운동의 다양성을 증가시킬 수 있습니다 [57]. 이 네 개의 샘플의 타임스탬프를 t-3, t-2, t-1 및 t로 표시합니다. 첫 번째 세 타임스탬프의 샘플은 반복적으로 BEV 특징 {Bt-3, Bt-2, Bt-1}를 생성하고, 이 단계에서는 그래디언트가 필요하지 않습니다. t-3 타임스탬프의 첫 번째 샘플의 경우 이전 BEV 특징이 없으므로 시간적 자기 어텐션은 자기 어텐션으로 변합니다. t 시간에 모델은 멀티 카메라 입력과 이전 BEV 특징 Bt-1을 기반으로 BEV 특징 Bt를 생성하여, Bt에는 네 개의 샘플을 가로지르는 시간 및 공간적 단서가 포함됩니다. 마지막으로, BEV 특징 Bt를 검출 및 분할 헤드로 입력하고 해당 손실 함수를 계산합니다.

추론 단계에서는 비디오 시퀀스의 각 프레임을 시간 순서대로 평가합니다. 이전 타임스탬프의 BEV 특징이 저장되고 다음에 사용되며, 이 온라인 추론 전략은 시간 효율적이고 실제 응용 프로그램과 일관성이 있습니다. 시간 정보를 활용하지만, 추론 속도는 다른 방법 [45, 47]과 비교 가능합니다.

4 Experiments

4.1 Datasets

두 가지 도전적인 자율주행 데이터셋인 nuScenes 데이터셋[4]과 Waymo 오픈 데이터셋[40]에서 실험을 수행합니다.

nuScenes 데이터셋[4]은 각각 약 20초의 지속시간을 가진 1000개의 장면으로 구성되어 있습니다. 데이터셋의 주요 샘플은 2Hz로 주석이 달려 있으며, 6개의 카메라에서의 RGB 이미지를 포함하고 있으며 수평 360° 시야각을 갖고 있습니다. 감지 작업을 위해 10개의 범주에 속하는 1.4백만 개의 주석이 달린 3D 경계 상자가 있습니다. BEV 분할 작업은 [32]의 설정을 따릅니다. 감지 작업을 위한 평가 지표에는 평균 평균 정밀도(mAP)가 포함되어 있으며, 이는 3D IoU가 아닌 지면 평면에서의 중심 거리를 사용하여 예측 결과와 실제값을 일치시킵니다. nuScenes 평가 지표에는 변위, 크기, 방향, 속도 및 속성 오차를 측정하기 위한 다섯 가지 유사 양성 지표(ATE, ASE, AOE, AVE, AAE)도 포함되어 있습니다. 또한 nuScenes는 nuScenes 감지 점수(NDS)를 정의하여 nuScenes 감지 작업의 모든 측면을 포착합니다.

Waymo Open Dataset[40]은 798개의 훈련 시퀀스와 202개의 검증 시퀀스로 구성된 대규모 자율주행 데이터셋입니다. Waymo에서 제공하는 각 프레임의 다섯 개의 이미지는 약 252°의 수평 시야각을 갖고 있지만, 제공되는 주석된 레이블은 이고 차량 주변을 360°로 커버합니다. 훈련 및 검증 이미지 중 어느 이미지에도 보이지 않는 경계 상자는 제거됩니다. Waymo Open Dataset은 대규모이고 높은 속도의 특성으로 인해 훈련 시퀀스에서 매 5번째 프레임을 샘플링하여 차량 범주만 감지합니다. Waymo 데이터셋에서의 mAP는 3D IoU 임계값을 0.5와 0.7로 사용하여 계산됩니다.

4.2 실험 설정

두 가지 유형의 백본을 채택하였습니다: FCOS3D [45] 체크포인트에서 초기화된 ResNet101-DCN [15, 12] 및 DD3D [31] 체크포인트에서 초기화된 VoVnet-99 [21]입니다. 이전 연구[45, 47, 31]를 따라 FPN [23]의 다중 스케일 특징 출력 크기인 1/16, 1/32 및 1/64와 C = 256의 차원을 사용합니다. nuScenes에서의 실험에 대해서는 BEV 쿼리의 기본 크기는 200×200이며, X 및 Y 축에 대한 인식 범위는 [-51.2m, 51.2m]이고 BEV의 그리드 해상도 크기인 s는 0.512m입니다. BEV 쿼리에 대해 학습 가능한 위치 임베딩을 사용합니다. BEV 인코더는 6개의 인코더 레이어로 구성되며, 각 레이어에서 BEV 쿼리를 지속적으로 개선합니다. 각 인코더 레이어의 입력 BEV 피처 Bt−1은 동일하며 그라디언트를 필요로하지 않습니다. 공간 교차 어텐션 모듈에서는 변형 어텐션 메커니즘을 사용하여 각 로컬 쿼리가 3D 공간에서 다른 높이를 가진 Nref = 4개의 타겟 포인트에 해당합니다. 미리 정의된 높이 앵커는 -5 미터부터 3 미터까지 균등하게 샘플링됩니다. 2D 뷰 피처 상의 각 참조 포인트에 대해 각 헤드에 대해 이 참조 포인트 주위에 네 개의 샘플링 포인트를 사용합니다. 모델은 24개의 epoch과 2×10−4의 학습 속도로 훈련됩니다.

Waymo에서의 실험에 대해서는 몇 가지 설정을 변경합니다. Waymo의 카메라 시스템은 주행자차 주변의 전체 장면을 캡처할 수 없기 때문에 BEV 쿼리의 기본 공간 형상은 300×220이고, X 축에 대한 인식 범위는 [-35.0m, 75.0m]이고 Y 축에 대한 인식 범위는 [-75.0m, 75.0m]입니다. 각 그리드의 해상도 s는 0.5m입니다. BEV에서 자율주행 차량은 (70, 150)에 위치합니다.

기준 모델은 작업 헤드의 영향을 제거하고 다른 BEV 생성 방법과 공정하게 비교하기 위해 VPN [30]과 Lift-Splat [32]을 사용하여 BEVFormer를 대체하고 작업 헤드 및 기타 설정은 동일하게 유지합니다. 또한, 역사적인 BEV 피처를 사용하지 않고 일반적인 self-attention을 사용하여 시간적 self-attention을 조정하여 정적 모델인 BEVFormer-S로 BEVFormer를 적응시킵니다.

4.3 3D Object Detection Results (3D 객체 감지 결과)

우리는 공정한 비교를 위해 3D 객체 감지 작업에서 감지 헤드만을 사용하여 모델을 훈련시켰습니다. 표 1과 표 2에는 nuScenes 테스트 및 검증 데이터셋에서의 주요 결과를 보고합니다. 우리의 방법은 공정한 훈련 전략과 비슷한 모델 규모에서 이전 최고 성능 모델인 DETR3D [47]보다 검증 데이터셋에서 9.2 포인트 더 높은 성능을 보여줍니다. (51.7% NDS 대 42.5% NDS). 테스트 데이터셋에서는 추가적인 기법 없이도 56.9% NDS를 달성하여 DETR3D보다 9.0 포인트 높은 성능을 보입니다 (47.9% NDS). 우리의 방법은 SSN (56.9% NDS) [55] 및 PointPainting (58.1% NDS) [43]과 같은 일부 LiDAR 기반 베이스라인과도 비교 가능한 성능을 달성할 수 있습니다.

이전의 카메라 기반 방법들 [47, 31, 45]은 거의 속도를 추정하지 못했으며, 우리의 방법은 다중 카메라 감지에서 속도 추정에 있어서 시간 정보가 중요한 역할을 한다는 것을 보여줍니다. BEVFormer의 평균 속도 오차(mAVE)는 테스트 데이터셋에서 0.378 m/s로, 다른 카메라 기반 방법들과 비교하여 큰 차이로 우수한 성능을 보여주며, LiDAR 기반 방법들 [43]의 성능에 근접합니다.

또한 Waymo에서도 실험을 수행하였으며, 표 3에 결과를 보여줍니다. [34]에 따라 우리는 0.7과 0.5의 IoU 기준으로 차량 카테고리를 평가합니다. 또한 IoU 기반 지표가 카메라 기반 방법에게는 너무 어려운 경우에는 nuScenes의 지표를 사용하여 결과를 평가합니다. Waymo에서 결과를 보고한 카메라 기반 작업은 몇 개뿐이므로 DETR3D의 공식 코드를 사용하여 실험을 수행합니다. BEVFormer는 0.5의 IoU 기준으로 LEVEL_1 및 LEVEL_2의 난이도에서 DETR3D보다 Heading 정보를 포함한 평균 정밀도 (APH) [40]에서 6.0%와 2.5% 더 우수한 성능을 보입니다. nuScenes 지표에서는 BEVFormer가 3.2% NDS와 5.2% AP로 DETR3D보다 우수한 성능을 보입니다. 또한 Waymo 데이터셋에서 결과를 보고한 단일 카메라 3D 감지 방법인 CaDNN [34]과 BEVFormer를 비교하기 위해 전방 카메라에서도 실험을 수행합니다. BEVFormer는 0.5의 IoU 기준으로 LEVEL_1 및 LEVEL_2의 난이도에서 APH에서 13.3%와 11.2%로 CaDNN보다 더 우수한 성능을 보입니다.

4.4 Multi-tasks Perception Results (다중 작업 인식 결과)

우리는 감지와 분할 헤드를 함께 사용하여 모델의 다중 작업 학습 능력을 검증하기 위해 모델을 훈련시켰으며, 결과는 표 4에 나와 있습니다. 동일한 설정에서 다른 BEV 인코더를 비교하는 과정에서 BEVFormer는 도로 분할 결과를 제외하고는 모든 작업에서 더 높은 성능을 달성합니다. 예를 들어, 공동 훈련으로 BEVFormer는 detation 작업에서 Lift-Splat∗ [32]보다 11.0 포인트 (52.0% NDS 대 41.0% NDS)와 차선 분할에서 5.6 포인트의 IoU (23.9% 대 18.3%)로 우수한 성능을 보입니다. 개별적으로 작업을 훈련시키는 것과 비교하면, 다중 작업 학습은 계산 비용을 절약하고 백본 및 BEV 인코더와 같은 모듈을 공유하여 추론 시간을 줄입니다. 본 논문에서는 BEV 인코더가 다른 작업에 적절하게 적응되며, 다중 작업 헤드로 모델을 훈련시키면 감지 작업과 차량 분할 작업에서 더 나은 성능을 발휘한다는 것을 보여줍니다. 그러나 공동으로 훈련된 모델은 도로 및 차선 분할 작업에서 개별적으로 훈련된 모델만큼 성능이 좋지 않습니다. 이는 다중 작업 학습에서 일반적인 현상으로 알려진 부정적인 전이(negative transfer) [11, 13]입니다.

4.5 Ablation Study (제거 실험)

다양한 모듈의 효과를 자세히 살펴보기 위해 우리는 검증 데이터셋인 nuScenes val에서 감지 헤드에 대한 제거 실험을 수행합니다. 추가적인 제거 실험은 부록에 있습니다.

공간 교차 어텐션의 효과: 공간 교차 어텐션의 효과를 확인하기 위해 BEVFormer-S를 사용하여 시간 정보의 간섭을 제외한 제거 실험을 수행하고 결과를 표 5에 보여줍니다. 기본 공간 교차 어텐션은 변형 가능한 어텐션에 기반합니다. 비교를 위해 다른 어텐션 메커니즘을 사용하는 두 가지 기준을 구축합니다: (1) 변형 가능한 어텐션을 대체하기 위해 전역 어텐션을 사용합니다. (2) 각 쿼리는 주변 지역이 아닌 참조 포인트와만 상호 작용하도록하며, 이는 이전의 방법 [36, 37]과 유사합니다. 보다 포괄적인 비교를 위해 BEVFormer를 VPN [30]과 Lift-Spalt [32]에서 제안한 BEV 생성 방법으로 대체합니다. 우리는 변형 가능한 어텐션이 모델 규모가 비슷한 다른 어텐션 메커니즘보다 훨씬 우수한 성능을 보여준다는 것을 관찰할 수 있습니다. 전역 어텐션은 GPU 메모리를 많이 소비하고, 포인트 상호 작용은 한정된 수용 영역을 가지고 있습니다. 희소 어텐션은 관심 영역을 사전에 결정하여 수용 영역과 GPU 소비를 균형있게 조절하기 때문에 더 나은 성능을 달성합니다.

시간적 자기 어텐션의 효과: 표 1과 표 4에서는 동일한 설정에서 BEVFormer가 BEVFormer-S보다 높은 성능을 보이며, 특히 어려운 감지 작업에서 탁월한 개선이 있습니다. 시간 정보의 효과는 주로 다음과 같은 측면에서 나타납니다: (1) 시간 정보의 도입은 속도 추정의 정확도에 큰 이점을 제공합니다. (2) 시간 정보와 함께 예측된 객체의 위치와 방향이 더 정확합니다. (3) 과거 객체의 단서를 포함하기 때문에 강하게 가려진 객체에 대해 더 높은 회수를 얻을 수 있습니다(그림 3 참조). 서로 다른 가려짐 수준을 가진 객체에 대한 BEVFormer의 성능을 평가하기 위해 nuScenes의 검증 데이터셋을 nuScenes에서 제공하는 공식 가시성 레이블에 따라 네 개의 하위 집합으로 분할합니다. 각 하위 집합에서 일치하는 동안 중심 거리 임계값이 2미터인 모든 카테고리의 평균 회수를 계산합니다. 모든 방법에서 최대 예측 상자 수는 300으로 설정하여 공정한 회수 비교를 수행합니다. 오직 0-40%의 객체만 가시적인 하위 집합에서 BEVFormer의 평균 회수는 BEVFormer-S 및 DETR3D보다 6.0% 이상의 차이로 우수한 성능을 보입니다.

모델 규모와 대기 시간: 표 6에서 다른 구성의 성능과 대기 시간을 비교합니다. BEVFormer의 규모를 다음 세 가지 측면에서 제거하여 성능과 추론 대기 시간 사이의 트레이드 오프를 검증합니다. 다중 스케일 뷰 피쳐를 사용할지 여부, BEV 쿼리의 형태 및 레이어 수를 포함합니다. 우리는 BEVFormer에서 엔코더 레이어를 하나만 사용하는 구성 C를 사용하여 50.1% NDS의 성능을 달성하고 BEVFormer의 대기 시간을 원래의 130ms에서 25ms로 줄입니다. 단일 스케일 뷰 피쳐, 더 작은 BEV 크기 및 단 하나의 엔코더 레이어를 사용하는 구성 D는 기본 구성과 비교하여 3.9 포인트를 잃지만 추론 중에는 7ms만 소비합니다. 그러나 다중 뷰 이미지 입력으로 인해 효율성을 제한하는 병목은 백본에 있으며, 자율 주행을 위한 효율적인 백본은 깊이 있는 연구가 필요합니다. 전반적으로 우리의 구조는 다양한 모델 규모에 적응하고 성능과 효율성 사이의 트레이드 오프를 유연하게 조절할 수 있습니다./

4.6 시각화 결과

그림 4에서 복잡한 장면의 감지 결과를 보여줍니다. BEVFormer는 작고 먼 객체에서 일부 오류를 제외하고 인상적인 결과를 생성합니다. 추가적인 질적인 결과는 부록에서 제공됩니다.

5 토론 및 결론 본 연구에서 우리는 다중 카메라 입력에서 새누리(鳥瞰圖) 기능을 생성하기 위해 BEVFormer를 제안했습니다. BEVFormer는 효율적으로 공간 및 시간 정보를 집계하고, 3D 감지 및 맵 세분화 작업을 동시에 지원하는 강력한 BEV 기능을 생성할 수 있습니다.

한계점. 현재 카메라 기반 방법은 효과와 효율성 측면에서 여전히 LiDAR 기반 방법과의 특정한 격차를 가지고 있습니다. 2D 정보에서 3D 위치의 정확한 추론은 카메라 기반 방법에 대한 오랜 도전 과제입니다.

보다 폭넓은 영향. BEVFormer는 다중 카메라 입력에서의 시공간 정보 활용이 시각 인지 모델의 성능을 크게 향상시킬 수 있음을 보여줍니다. BEVFormer에 의해 시연된 장점들(더 정확한 속도 추정 및 낮은 가시성 객체에 대한 더 높은 회수)은 더 나은 및 안전한 자율 주행 시스템 및 그 이상을 구축하는 데 중요합니다. 우리는 BEVFormer가 후속 연구에서 더 강력한 시각 인지 방법의 기초에 불과하며, 시각 기반 인지 시스템은 아직 탐구되어야 할 엄청난 잠재력을 가지고 있다고 믿습니다.

References

[1] Brazil, G., Liu, X.: M3d-rpn: Monocular 3d region proposal network for object detection. In:

Proceedings of the IEEE/CVF International Conference on Computer Vision. pp. 9287–9296

(2019)

[2] Brazil, G., Pons-Moll, G., Liu, X., Schiele, B.: Kinematic 3d object detection in monocular

video. In: European Conference on Computer Vision. pp. 135–152. Springer (2020)

[3] Bruls, T., Porav, H., Kunze, L., Newman, P.: The right (angled) perspective: Improving the

understanding of road scenes using boosted inverse perspective mapping. In: 2019 IEEE

Intelligent Vehicles Symposium (IV). pp. 302–309. IEEE (2019)

[4] Caesar, H., Bankiti, V., Lang, A.H., Vora, S., Liong, V.E., Xu, Q., Krishnan, A., Pan, Y., Baldan,

G., Beijbom, O.: nuscenes: A multimodal dataset for autonomous driving. In: Proceedings of

the IEEE/CVF conference on computer vision and pattern recognition. pp. 11621–11631 (2020)

[5] Can, Y.B., Liniger, A., Paudel, D.P., Van Gool, L.: Structured bird’s-eye-view traffic scene

understanding from onboard images. In: Proceedings of the IEEE/CVF International Conference

on Computer Vision. pp. 15661–15670 (2021)

[6] Can, Y.B., Liniger, A., Unal, O., Paudel, D., Van Gool, L.: Understanding bird’s-eye view

semantic hd-maps using an onboard monocular camera. arXiv preprint arXiv:2012.03040 (2020)

[7] Carion, N., Massa, F., Synnaeve, G., Usunier, N., Kirillov, A., Zagoruyko, S.: End-to-end

object detection with transformers. In: European conference on computer vision. pp. 213–229.

Springer (2020)

[8] Chen, X., Ma, H., Wan, J., Li, B., Xia, T.: Multi-view 3d object detection network for au-

tonomous driving. In: Proceedings of the IEEE conference on Computer Vision and Pattern

Recognition. pp. 1907–1915 (2017)

[9] Chitta, K., Prakash, A., Geiger, A.: Neat: Neural attention fields for end-to-end autonomous

driving. In: Proceedings of the IEEE/CVF International Conference on Computer Vision. pp.

15793–15803 (2021)

[10] Cho, K., Van Merriënboer, B., Bahdanau, D., Bengio, Y.: On the properties of neural machine

translation: Encoder-decoder approaches. arXiv preprint arXiv:1409.1259 (2014)

[11] Crawshaw, M.: Multi-task learning with deep neural networks: A survey. arXiv preprint

arXiv:2009.09796 (2020)

[12] Dai, J., Qi, H., Xiong, Y., Li, Y., Zhang, G., Hu, H., Wei, Y.: Deformable convolutional networks.

In: Proceedings of the IEEE international conference on computer vision. pp. 764–773 (2017)

[13] Fifty, C., Amid, E., Zhao, Z., Yu, T., Anil, R., Finn, C.: Efficiently identifying task groupings

for multi-task learning. Advances in Neural Information Processing Systems 34 (2021)

[14] Gehring, J., Auli, M., Grangier, D., Yarats, D., Dauphin, Y.N.: Convolutional sequence to

sequence learning. In: International Conference on Machine Learning. pp. 1243–1252. PMLR

(2017)

[15] He, K., Zhang, X., Ren, S., Sun, J.: Deep residual learning for image recognition. In: Pro-

ceedings of the IEEE conference on computer vision and pattern recognition. pp. 770–778

(2016)

[16] Hendy, N., Sloan, C., Tian, F., Duan, P., Charchut, N., Xie, Y., Wang, C., Philbin, J.: Fishing

net: Future inference of semantic heatmaps in grids. arXiv preprint arXiv:2006.09917 (2020)

[17] Hochreiter, S., Schmidhuber, J.: Long short-term memory. Neural computation 9(8), 1735–1780

(1997)

12

[18] Hu, A., Murez, Z., Mohan, N., Dudas, S., Hawke, J., Badrinarayanan, V., Cipolla, R., Kendall,

A.: Fiery: Future instance prediction in bird’s-eye view from surround monocular cameras. In:

Proceedings of the IEEE/CVF International Conference on Computer Vision. pp. 15273–15282

(2021)

[19] Kang, K., Ouyang, W., Li, H., Wang, X.: Object detection from video tubelets with convolutional

neural networks. In: Proceedings of the IEEE conference on computer vision and pattern

recognition. pp. 817–825 (2016)

[20] Lang, A.H., Vora, S., Caesar, H., Zhou, L., Yang, J., Beijbom, O.: Pointpillars: Fast encoders for

object detection from point clouds. In: Proceedings of the IEEE/CVF Conference on Computer

Vision and Pattern Recognition. pp. 12697–12705 (2019)

[21] Lee, Y., Hwang, J.w., Lee, S., Bae, Y., Park, J.: An energy and gpu-computation efficient

backbone network for real-time object detection. In: Proceedings of the IEEE/CVF Conference

on Computer Vision and Pattern Recognition Workshops. pp. 0–0 (2019)

[22] Li, Z., Wang, W., Xie, E., Yu, Z., Anandkumar, A., Alvarez, J.M., Lu, T., Luo, P.: Panop-

tic segformer: Delving deeper into panoptic segmentation with transformers. arXiv preprint

arXiv:2109.03814 (2021)

[23] Lin, T.Y., Dollár, P., Girshick, R.B., He, K., Hariharan, B., Belongie, S.J.: Feature pyramid net-

works for object detection. 2017 IEEE Conference on Computer Vision and Pattern Recognition

(CVPR) pp. 936–944 (2017)

[24] Loshchilov, I., Hutter, F.: Sgdr: Stochastic gradient descent with warm restarts. arXiv: Learning

(2017)

[25] Loshchilov, I., Hutter, F.: Decoupled weight decay regularization. In: ICLR (2019)

[26] Luo, W., Yang, B., Urtasun, R.: Fast and furious: Real time end-to-end 3d detection, tracking

and motion forecasting with a single convolutional net. In: Proceedings of the IEEE conference

on Computer Vision and Pattern Recognition. pp. 3569–3577 (2018)

[27] Ma, X., Ouyang, W., Simonelli, A., Ricci, E.: 3d object detection from images for autonomous

driving: A survey. arXiv preprint arXiv:2202.02980 (2022)

[28] Mousavian, A., Anguelov, D., Flynn, J., Kosecka, J.: 3d bounding box estimation using deep

learning and geometry. In: Proceedings of the IEEE conference on Computer Vision and Pattern

Recognition. pp. 7074–7082 (2017)

[29] Ng, M.H., Radia, K., Chen, J., Wang, D., Gog, I., Gonzalez, J.E.: Bev-seg: Bird’s eye view se-

mantic segmentation using geometry and semantic point cloud. arXiv preprint arXiv:2006.11436

(2020)

[30] Pan, B., Sun, J., Leung, H.Y.T., Andonian, A., Zhou, B.: Cross-view semantic segmentation for

sensing surroundings. IEEE Robotics and Automation Letters 5(3), 4867–4873 (2020)

[31] Park, D., Ambrus, R., Guizilini, V., Li, J., Gaidon, A.: Is pseudo-lidar needed for monocular

3d object detection? In: Proceedings of the IEEE/CVF International Conference on Computer

Vision. pp. 3142–3152 (2021)

[32] Philion, J., Fidler, S.: Lift, splat, shoot: Encoding images from arbitrary camera rigs by

implicitly unprojecting to 3d. In: European Conference on Computer Vision. pp. 194–210.

Springer (2020)

[33] Qi, C.R., Zhou, Y., Najibi, M., Sun, P., Vo, K., Deng, B., Anguelov, D.: Offboard 3d object de-

tection from point cloud sequences. In: Proceedings of the IEEE/CVF Conference on Computer

Vision and Pattern Recognition. pp. 6134–6144 (2021)

[34] Reading, C., Harakeh, A., Chae, J., Waslander, S.L.: Categorical depth distribution network

for monocular 3d object detection. In: Proceedings of the IEEE/CVF Conference on Computer

Vision and Pattern Recognition. pp. 8555–8564 (2021)

[35] Reiher, L., Lampe, B., Eckstein, L.: A sim2real deep learning approach for the transformation

of images from multiple vehicle-mounted cameras to a semantically segmented image in bird’s

eye view. In: 2020 IEEE 23rd International Conference on Intelligent Transportation Systems

(ITSC). pp. 1–7. IEEE (2020)

[36] Roddick, T., Kendall, A., Cipolla, R.: Orthographic feature transform for monocular 3d object

detection. In: BMVC (2019)

13

[37] Rukhovich, D., Vorontsova, A., Konushin, A.: Imvoxelnet: Image to voxels projection

for monocular and multi-view general-purpose 3d object detection. In: Proceedings of the

IEEE/CVF Winter Conference on Applications of Computer Vision. pp. 2397–2406 (2022)

[38] Saha, A., Maldonado, O.M., Russell, C., Bowden, R.: Translating images into maps. arXiv

preprint arXiv:2110.00966 (2021)

[39] Simonelli, A., Bulo, S.R., Porzi, L., Lopez-Antequera, M., Kontschieder, P.: Disentangling

monocular 3d object detection. In: Proceedings of the IEEE/CVF International Conference on

Computer Vision (ICCV) (October 2019)

[40] Sun, P., Kretzschmar, H., Dotiwalla, X., Chouard, A., Patnaik, V., Tsui, P., Guo, J., Zhou,

Y., Chai, Y., Caine, B., et al.: Scalability in perception for autonomous driving: Waymo

open dataset. In: Proceedings of the IEEE/CVF conference on computer vision and pattern

recognition. pp. 2446–2454 (2020)

[41] Tian, Z., Shen, C., Chen, H., He, T.: Fcos: Fully convolutional one-stage object detection. In:

Proceedings of the IEEE/CVF international conference on computer vision. pp. 9627–9636

(2019)

[42] Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A.N., Kaiser, Ł.,

Polosukhin, I.: Attention is all you need. Advances in neural information processing systems 30

(2017)

[43] Vora, S., Lang, A.H., Helou, B., Beijbom, O.: Pointpainting: Sequential fusion for 3d ob-

ject detection. In: Proceedings of the IEEE/CVF conference on computer vision and pattern

recognition. pp. 4604–4612 (2020)

[44] Wang, T., Xinge, Z., Pang, J., Lin, D.: Probabilistic and geometric depth: Detecting objects in

perspective. In: Conference on Robot Learning. pp. 1475–1485. PMLR (2022)

[45] Wang, T., Zhu, X., Pang, J., Lin, D.: Fcos3d: Fully convolutional one-stage monocular 3d object

detection. In: Proceedings of the IEEE/CVF International Conference on Computer Vision. pp.

913–922 (2021)

[46] Wang, Y., Chao, W.L., Garg, D., Hariharan, B., Campbell, M., Weinberger, K.Q.: Pseudo-lidar

from visual depth estimation: Bridging the gap in 3d object detection for autonomous driving.

In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp.

8445–8453 (2019)

[47] Wang, Y., Guizilini, V.C., Zhang, T., Wang, Y., Zhao, H., Solomon, J.: Detr3d: 3d object

detection from multi-view images via 3d-to-2d queries. In: Conference on Robot Learning. pp.

180–191. PMLR (2022)

[48] Xie, E., Yu, Z., Zhou, D., Philion, J., Anandkumar, A., Fidler, S., Luo, P., Alvarez, J.M.: Mˆ 2bev:

Multi-camera joint 3d detection and segmentation with unified birds-eye view representation.

arXiv preprint arXiv:2204.05088 (2022)

[49] Xu, B., Chen, Z.: Multi-level fusion based 3d object detection from monocular images. In:

Proceedings of the IEEE conference on computer vision and pattern recognition. pp. 2345–2353

(2018)

[50] Yan, Y., Mao, Y., Li, B.: Second: Sparsely embedded convolutional detection. Sensors 18(10),

3337 (2018)

[51] Yang, W., Li, Q., Liu, W., Yu, Y., Ma, Y., He, S., Pan, J.: Projecting your view attentively:

Monocular road scene layout estimation via cross-view transformation. In: Proceedings of the

IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp. 15536–15545 (2021)

[52] Yin, T., Zhou, X., Krahenbuhl, P.: Center-based 3d object detection and tracking. In: Proceedings

of the IEEE/CVF conference on computer vision and pattern recognition. pp. 11784–11793

(2021)

[53] Zhou, X., Wang, D., Krähenbühl, P.: Objects as points. arXiv preprint arXiv:1904.07850 (2019)

[54] Zhou, Y., Tuzel, O.: Voxelnet: End-to-end learning for point cloud based 3d object detection. In:

Proceedings of the IEEE conference on computer vision and pattern recognition. pp. 4490–4499

(2018)

[55] Zhu, X., Ma, Y., Wang, T., Xu, Y., Shi, J., Lin, D.: Ssn: Shape signature networks for multi-class

object detection from point clouds. In: European Conference on Computer Vision. pp. 581–597.

Springer (2020)

14

[56] Zhu, X., Su, W., Lu, L., Li, B., Wang, X., Dai, J.: Deformable detr: Deformable transformers for

end-to-end object detection. In: International Conference on Learning Representations (2020)

[57] Zhu, X., Xiong, Y., Dai, J., Yuan, L., Wei, Y.: Deep feature flow for video recognition. In:

Proceedings of the IEEE conference on computer vision and pattern recognition. pp. 2349–2358

(2017)